Sebutkan Pihak Pihak Yang Menggunakan Penerapan Teknologi Dan Informasi – Penyelenggaraan administrasi pemerintahan dan pelayanan publik tentunya memerlukan penggunaan teknologi informasi dan komunikasi serta sumber daya manusia yang handal untuk mengelolanya.

Pemerintah menggunakan teknologi informasi yang memiliki kemampuan untuk menghubungkan kebutuhan warga negara, bisnis, dan aktivitas lainnya, seperti penggunaan intranet dan internet. Dapat berupa proses transaksi bisnis antara masyarakat dengan pemerintah melalui sistem otomatis dan jaringan internet yang dikenal dengan World Wide Web (www).

Sebutkan Pihak Pihak Yang Menggunakan Penerapan Teknologi Dan Informasi

Pemanfaatan teknologi informasi yang dapat meningkatkan hubungan antara pemerintah dengan pihak lain. Manfaat nyata dari e-government meliputi:

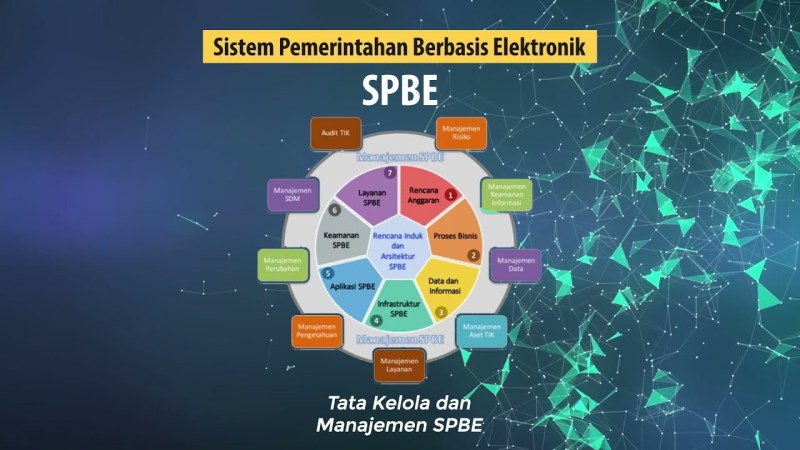

Sistem Pemerintahan Berbasis Elektronik

Informasi dapat diberikan 24/7 tanpa harus menunggu kantor buka. Anda dapat menemukan informasi di kantor atau rumah Anda tanpa harus langsung ke kantor pemerintah.

Adanya keterbukaan (transparansi) diharapkan dapat meningkatkan hubungan antara berbagai pihak. Keterbukaan ini menghilangkan rasa saling curiga dan dendam semua pihak.

Dengan informasi yang cukup, orang akan belajar menentukan pilihan. Misalnya, data tentang sekolah: jumlah kelas, jumlah siswa, nilai kelulusan, dll ditampilkan di Internet dan dapat digunakan oleh orang tua untuk memilih sekolah yang tepat untuk anaknya.

Koordinasi pemerintah, misalnya, bisa dilakukan melalui e-mail atau video conference. Hal ini sangat bermanfaat bagi Indonesia yang memiliki wilayah yang sangat luas. Tanya jawab, koordinasi dan diskusi antar pimpinan daerah dapat berlangsung tanpa harus berada dalam satu tempat fisik yang sama. Tidak lagi semua orang harus terbang ke Jakarta untuk rapat yang berlangsung satu atau dua jam.

Desain Kebijakan Tata Kelola Konten Internet By Tifa Foundation

Tuntutan masyarakat akan tata kelola pemerintahan yang baik begitu mendesak sehingga pejabat pemerintah harus memenuhinya. Salah satu solusi yang diperlukan adalah integrasi sistem penyelenggaraan pemerintahan melalui jaringan sistem informasi online antara otoritas pemerintah pusat dan daerah untuk menjamin akses terhadap semua data dan informasi, khususnya informasi yang berkaitan dengan pelayanan publik.

Perubahan lingkungan strategis dan kemajuan teknologi di sektor pemerintahan telah mendorong aparatur pemerintah mengantisipasi paradigma baru dengan meningkatkan kinerja birokrasi dan meningkatkan pelayanan untuk mewujudkan good governance. Hal yang paling penting untuk diperhatikan adalah bahwa sektor pemerintah menggerakkan dan memungkinkan keberhasilan berbagai kegiatan pembangunan, sehingga keberhasilan pembangunan harus didukung oleh kecepatan informasi dan arus informasi antar lembaga. Teknologi khusus untuk mengatasi tantangan data besar pemerintah dan pengguna lainnya. Untuk mengatasi masalah volume, teknologi data besar menggunakan teknologi penyimpanan dan pemrosesan data terdistribusi. Masalah kecepatan diatasi menggunakan aliran dan pemrosesan terdistribusi.

Berbagai masalah diatasi dengan menggunakan teknik integrasi data dan penyimpanan data yang tidak terstruktur (on-write). Struktur ditentukan pada saat pembacaan data (at the time reading).

Teknologi big data yang populer saat ini adalah teknologi Hadoop. Hadoop awalnya dikembangkan oleh Google (Ghemawat et al., 2003) dan kemudian menjadi proyek Apache yang independen.

Dampak Kerusakan Hutan Bagi Manusia (update 2022)

Prinsip utama teknologi Hadoop adalah penyimpanan terdistribusi dan pemrosesan komputer komoditas yang terhubung ke jaringan (juga dikenal sebagai cluster).

Inti dari teknologi Hadoop adalah Hadoop Distributed File System (HDFS) untuk menangani penyimpanan data terdistribusi dan Pengurangan Peta untuk pemrosesan data terdistribusi yang dilakukan di komputer tempat data disimpan (node dalam cluster).

Untuk mengatasi berbagai masalah komputasi, Hadoop didukung oleh berbagai teknologi yang dikenal secara kolektif sebagai Ekosistem Hadoop.

Data besar adalah istilah umum untuk teknologi dan teknik yang memproses dan menganalisis sejumlah besar data terstruktur, semi terstruktur, dan tidak terstruktur.

Sebutkan Teknologi Big Data Apa Saja Yang Termasuk Didalamnya?

Ada banyak tantangan yang Anda hadapi saat menangani big data, mulai dari cara mengambil dan menyimpan data hingga masalah keamanan informasi.

Meski istilah Big Data sudah sering terdengar dan disebut, banyak dari kita yang masih bertanya-tanya apa itu Big Data. Untuk apa data besar? Apa itu teknologi data besar? Mengapa kita membutuhkan data besar di berbagai bidang? Apa yang dimaksud dengan data besar?

Tidak ada definisi standar untuk data besar. Dalam arti luas, Big Data adalah kumpulan data dengan jumlah yang sangat besar atau struktur yang kompleks yang tidak dapat diolah dengan baik dengan teknologi pengolahan data yang ada. Saat ini istilah big data sering digunakan untuk merujuk pada disiplin ilmu atau teknologi yang terlibat dalam pengolahan dan pemanfaatan data tersebut.

Aspek terpenting dari Big Data bukanlah seberapa banyak data yang sebenarnya dapat disimpan dan diproses, tetapi kegunaan atau nilai tambah apa yang dapat diperoleh dari data tersebut. Jika tidak ada nilai tambah yang diambil, data menjadi sampah yang tidak berguna. Nilai tambah ini dapat digunakan untuk berbagai keperluan, seperti meningkatkan kelancaran operasional, meningkatkan akurasi penjualan, meningkatkan kualitas layanan, memprediksi atau meramalkan pasar, dan lainnya.

Jenis Profesi Di Bidang Teknologi Informasi Yang Perlu Kamu Tah

Dalam bidang informatika ada istilah “garbage in the garbage out”. Alternatifnya, masukan sampah juga menghasilkan keluaran sampah. Masalahnya, jika input yang kita berikan ke sistem berkualitas rendah, outputnya tentu saja berkualitas rendah. Input di sini adalah data.

Oleh karena itu, memastikan kualitas input dan output pada setiap tahap pemrosesan data untuk mencapai hasil akhir yang berkualitas sangat penting untuk implementasi big data. Karakteristik data besar

Beberapa orang menambahkan satu lagi ke 4V untuk menjadikannya 5V, tetapi itu sepadan. Nilai ini sering didefinisikan sebagai potensi nilai sosial atau ekonomi yang dapat dibuat oleh data. Keempat karakteristik di atas (volume, kecepatan, variasi dan keaslian) harus diolah dan dianalisis untuk memberikan nilai atau manfaat bagi bisnis dan kehidupan. Oleh karena itu, ciri kelima sangat erat kaitannya dengan kemampuan mengolah data untuk menghasilkan output yang berkualitas. Apa itu teknologi data besar?

Kemajuan teknologi big data tidak lepas dari teknologi atau konsep open source. Istilah Big Data terus bergaung dengan pesatnya perkembangan teknologi open source yang mendukungnya.

Apa Itu Pajak? Berikut Pengertian, Fungsi, Manfaat & Tarifnya

Ini menyediakan teknologi data besar yang dibuat oleh banyak perusahaan besar dan digunakan oleh komunitas open source. Ini menjadi salah satu pendorong utama pengembangan big data.

Ada banyak teknologi open source yang populer di ekosistem big data, beberapa di antaranya: Apache Hadoop

Apache Hadoop adalah kerangka kerja yang memungkinkan penyimpanan terdistribusi dan pemrosesan data dalam jumlah besar di seluruh kluster komputer menggunakan model pemrograman sederhana.

Hadoop mengambil inspirasi dari teknologi milik Google seperti Google File System dan Google Map Reduce. Hadoop menyediakan tiga fitur utama: 1. Sistem penyimpanan terdistribusi

Aplikasi Teknologi Digital Dalam Kehidupan Sehari Hari Dan Manfaatnya

HDFS adalah file terdistribusi atau sistem penyimpanan data pada cluster Hadoop. HDFS terinspirasi oleh Sistem File Google. 2. Kerangka kerja untuk pemrosesan data paralel dan terdistribusi

MapReduce adalah model pemrograman untuk memproses data dalam jumlah besar secara terdistribusi dalam cluster Hadoop. MapReduce berjalan dan memproses data yang berada di HDFS. 3. Manajemen sumber daya terdesentralisasi

YARN memungkinkan banyak kerangka kerja komputasi paralel lainnya seperti Spark, Tez, Storm, dll. untuk bekerja pada kluster Hadoop dan mengakses data dalam HDFS. 4. Sarang Lebah

Apache Hive adalah framework SQL yang berjalan di atas Hadoop. Hive mendukung bahasa pemrograman SQL, yang memudahkan kueri dan analisis data dalam jumlah besar di atas Hadoop. Selain Hadoop, Hive juga dapat digunakan di atas sistem file terdistribusi lainnya seperti Amazon 5. AWS3 dan Alluxio.

Output Penting Dilakukannya Audit It Pada Organisasi

Dukungan SQL Hive membantu mem-porting aplikasi berbasis SQL ke Hadoop, terutama untuk sebagian besar aplikasi gudang data yang memerlukan penyimpanan besar dan sistem komputasi.

Awalnya, Hive dikembangkan oleh Facebook untuk digunakan sebagai sistem gudang data. Setelah berkontribusi pada komunitas open source, Hive dengan cepat tumbuh dan diadopsi serta dikembangkan secara luas oleh raksasa lain seperti Netflix dan Amazon.

Pada dasarnya, Hive hanyalah lapisan untuk menerjemahkan perintah SQL ke dalam kerangka komputasi terdistribusi. Hive dapat bekerja dengan kerangka kerja berbeda yang berjalan di atas Hadoop, seperti MapReduce, Tez, atau Spark. 6. Apache Spark

Apache Spark adalah kerangka kerja komputasi terdistribusi yang dibuat untuk pemrosesan data besar berkecepatan tinggi yang menggunakan algoritme berbeda dari MapReduce, tetapi dapat berjalan di Hadoop melalui BENANG.

Pt. Waskita Beton Precast, Tbk

Spark menyediakan API dalam Scala, Java, Python, dan SQL dan dapat digunakan untuk menjalankan banyak jenis proses secara efisien, termasuk ETL, streaming data, pembelajaran mesin, komputasi grafik, dan SQL.

Selain HDFS, Spark juga dapat digunakan di atas sistem file lain seperti Cassandra, Amazon AWS3, dan penyimpanan cloud lainnya. Fitur utama Spark adalah komputasi cluster dalam memori. Penggunaan memori ini dapat mempercepat rendering aplikasi Anda secara signifikan.

Spark banyak digunakan dalam pembelajaran mesin karena MapReduce lebih cocok untuk pemrosesan batch dari kumpulan data yang sangat besar, Spark sangat cocok untuk pemrosesan iteratif dan streaming langsung.

Spark adalah sub proyek Hadoop yang dikembangkan pada tahun 2009 di AMPLab UC Berkeley. Sejak 2009, lebih dari 1200 pengembang telah berkontribusi pada proyek Apache Spark. Selain 3 teknologi tersebut, sebenarnya ada banyak teknologi dan framework big data open source seperti HBase, Cassandra, Presto, Storm, Flink, NiFi, Sqoop, Flume, Kafka, dll. Pipa data besar

Pengaruh Kemajuan Teknologi Komunikasi Dan Informasi Terhadap Karakter Anak

Agar data memberikan nilai yang dapat digunakan, terlebih dahulu harus melalui berbagai langkah pemrosesan. Mulai dari perekaman/penciptaan, pengumpulan, penyimpanan, pengayaan, analisis dan pengolahan lebih lanjut hingga penyajian. Serangkaian proses data ini biasanya disebut sebagai pemipaan data.

Hari ini, ketika kita berbicara tentang data besar, yang biasanya kita maksud adalah analisis data besar. Ini sangat masuk akal, karena ketika proyek data besar dimulai, hasil akhir yang diharapkan adalah memperoleh wawasan berguna yang dapat membantu dalam pengambilan keputusan.

Analisis data itu sendiri adalah serangkaian proses penggalian informasi atau wawasan dari kumpulan data. Informasi ini dapat berupa pola, korelasi atau tren. Analisis data sering kali mencakup teknik dan algoritme pemrosesan data.

Penerapan teknologi informasi dan komunikasi dalam pendidikan, pihak eksternal yang menggunakan informasi akuntansi, pihak eksternal yang menggunakan informasi akuntansi adalah, penerapan erp merupakan penerapan teknologi informasi dalam bidang, informasi dan teknologi, teknologi informasi dan komunikasi, sebutkan dampak positif penggunaan teknologi informasi dan komunikasi, contoh penerapan teknologi informasi, sistem dan teknologi informasi, sebutkan pihak pihak yang membutuhkan informasi akuntansi, sebutkan peralatan teknologi informasi dan komunikasi, pihak yang membutuhkan informasi akuntansi